Toujours +

Pour

éviter que notre monde ne se réchauffe trop, nous devrions assurer notre confort

thermique dans l'habitat différemment. Ceci en évitant l’effet joule et en

refroidissant l'eau qui nous entoure afin de consommer nettement moins

d'électricité en hiver lorsqu'il fait froid quitte à en consommer un peu plus

l'été en la réchauffant pour climatiser l'habitat lorsqu’il fait trop chaud. La

consommation globale permettant de satisfaire notre confort thermique serait

ainsi satisfaite avec un besoin en énergie électrique plus faible ce qui

permettrait de diminuer quantativement voire de supprimer sa production

associée au nucléaire. La "Solar

Water Economy" dans les chapitres 2 et 3 du livre en apporte la

preuve. L'homo sapiens dit "moderne", le seul être au monde à avoir

besoin selon Dany d'eau potable pour chier dedans en apporte la preuve.

Heureusement cela ne va pas durer très longtemps ; l’eau potable ayant disparu,

il fera après ce qu'il aurait dû faire avant.

Selon

une perspective de l’OCDE datant de 2012, l’économie mondiale pourrait quadrupler à l’horizon 2050. Cela

ayant pour conséquence d’après cet organisme d’augmenter sensiblement la

consommation d’énergie de 80 % en 3 décennies. Cela correspond à une croissance

moyenne annuelle de l’économie mondiale pendant cette période voisine de 4%. Si

la consommation d’énergie devait effectivement comme le prévoit l’OCDE

augmenter de 80 % à l’horizon 2050 ce serait catastrophique et donnerait raison

à titre posthume au célèbre astrophysicien Stephen Hawking. Cela pourrait bien

se produire vu les réalisations

de grands pays comme la Chine qui ne font pourtant pas partie de

l’OCDE et aussi par le fait que les pays

en développement suivent quoiqu’on en dise notre exemple. Seule la mise en

place d’une politique plus efficace en faveur des énergies renouvelables

pourrait retarder la terrible échéance. Sinon les énergies fossiles devraient

encore représenter 85 % du mix énergétique et les émissions mondiales de gaz à

effet de serre augmenter de 50 % d’ici 2050 en raison, principalement, de la

croissance. Dans un tel scénario, la concentration atmosphérique de Gaz à Effet

de Serre (GES) pourrait atteindre 685 particules par millions (ppm) avec une

température mondiale augmentant de 3°C à 6°C par rapport aux températures

préindustrielles. Ceci bien au-delà de l’objectif des 2°C fixé par l’Accord de

Paris. Ce raisonnement

de l’OCDE intègre très probablement le fait que la population mondiale va atteindre sensiblement 9

milliards d’individus à cette échéance. Ces informations sont extrêmement

graves.

Il reste à espérer que la démission récente de notre ministre de l’écologie va créer un sursaut et que

notre nouveau ministre va réussir à concilier l’écologie et l’économie en

faisant preuve de pragmatisme étant donné l’urgence qu’il a à AGIR.

Si les projections de l’OCDE se

vérifient exactes, il est en effet clair que la politique mondiale de l’énergie

serait alors un échec. Les pays de l’OCDE seraient d’ailleurs en partie

responsables de cette situation vue que les pays en voie de développement

prennent exemple sur nous pays de l’OCDE alors que nous sommes de véritables

gloutons énergivores incapables pour l’instant de montrer l’exemple de ce qu’il

faut faire. Ceci selon l’IRENA avec une consommation voisine de 55 000 kWh

d’énergie finale par habitant avec le risque de courir à la catastrophe sur le

plan climatique. L’intérêt des pays dits développés comme les nôtres est de

montrer l’exemple de ce qu’il faut faire en assurant la mise en place de

politiques plus efficaces en faveur des énergies renouvelables. Ceci par

exemple pour ce qui concerne les gaz à effet de serre en convertissant les 4 centrales à charbon qui restent encore en fonctionnement en France

|

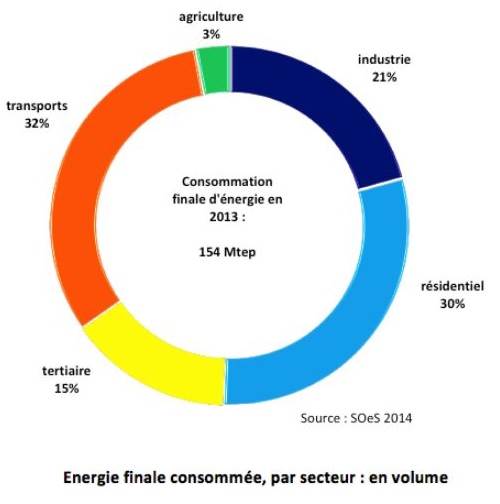

Il y a certes les secteurs de l’industrie et du transport

(aérien, routier et maritime) qui sont loin d’être négligeables mais la

consommation d’énergie finale assurant le chauffage de l’habitat est un poste

trop important notamment en France pays qui a vocation à montrer aux autres

pays du monde l’exemple de ce qu’il convient de faire suite aux accords de

Paris sur le climat. Le tertiaire dans le bâtiment correspond aux bâtiments occupés

par les activités du secteur tertiaire à savoir les commerces, les bureaux,

les hôpitaux, l'enseignement, infrastructures collectives destinées aux

sports, aux loisirs, aux transports, CHR (cafés/hôtels/restaurants), et tous

les établissements destinés à recevoir du public Voir

ci-contre la répartition de la consommation finale d’énergie par secteur en

France en 2013 (OIE) |

|

|

Cliquer sur l’image

pour en savoir + |

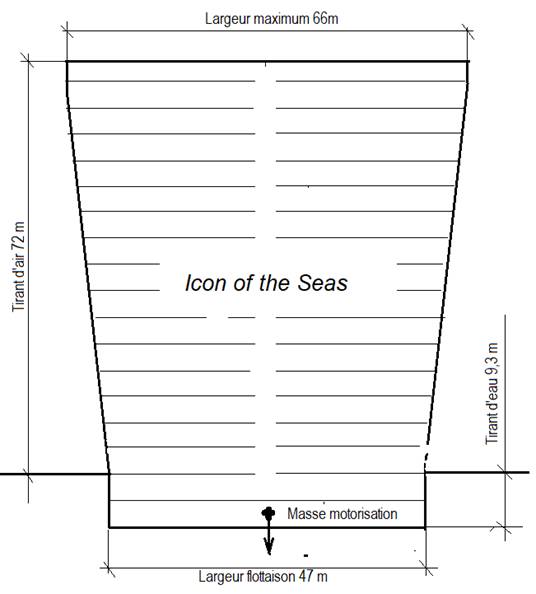

Le

transport maritime avec ses gigantesques portes container pouvant atteindre

400m de long et 54m de large joue un rôle important avec le transport routier

et aérien. Le fret transporté par ces monstres marins est composé

principalement d’hydrocarbures, de céréales, de produits manufacturés et de

matières premières. Le fioul lourd

utilisé par les énormes moteurs diesel en raison de la résistance dite de vague est loin d’être irréprochable en ce qui concerne

la pollution des mers. Le toujours + peut

être beau quant à la technique et terrifiant quant à l’humain |

|

La récente mise en service de

l'immense navire US "Icon of

the Seas" orienté vers le tourisme est le

symbole de la démesure. Sa stabilité est basée sur la masse importante

du moteur de propulsion situé dans ses soutes et

utilisant la combustion du gaz naturel. Il persiste à utiliser les

combustibles fossiles malgré la décision internationale prise début 2024 lors

de la COP 28 d'arrêter l'utilisation de la combustion et des produits. Caractéristiques

principales

|

|

Pour aller au fond des choses il nous faut aussi

tenir compte de l’alimentation non représenté sur la première figure. Ceci en

observant qu’un individu a besoin en moyenne de 2500 calories par jour pour se

nourrir. Ce chiffre étant majoré de 150 calories pour un individu actif et

diminué de la même valeur pour un individu n’ayant aucune activité physique. Un

grand sportif pouvant consommer jusqu’à 3250 calories. Mais attention il s’agit

ici de la calorie alimentaire. Il faut dans la pratique multiplier ces chiffres

par 1000 pour évaluer la consommation énergétique moyenne d’un individu si l’on

raisonne dans le système international (SI) en tenant compte de l’équivalent

mécanique de la calorie égal à 4,18 joules selon l’anglais James Prescott. Cela

revient à dire qu’un individu consomme en moyenne 2500 kilocalories par jour

soit 2500 × 4,18 = 10 450 kilojoules par jour ou encore 10 450 x 365 = 3 850

000 kilojoules par an ou encore vu que 3600 kilojoules correspondent à 1 kWh

sensiblement 1000 kWh annuellement.

Le

porte-parole du CSLT* a suggéré au travers de la « Solar Water Economy » de l’enthalpie, la mise en place

en France d’une modification des chaînes énergétiques actuelles assurant le

chauffage de l’habitat. Elle permettrait de diviser la consommation d’énergie

finale environ par 2,5 pour ce poste très important représentant en 2013 selon Observatoire de

l’Industrie Electrique (OIE) près

de 50 % (30 résidentiel +15% tertiaire) de la consommation totale d’énergie

consommée en France. Ceci certes au prix

d’un effort en ce qui concerne la mise en place d’un réseau d’eau non potable,

mais sans créer trop de contrainte sur le poste isolation vu la plus grande

difficulté d’isoler l’habitat « après coup ». Il serait peut-être

temps que la France suive les recommandations du chef spirituel du G20 et

montre l’exemple. Ce dernier n’estimait-il pas récemment « qu’il vaut

mieux faire partie de ceux qui établissent les règles plutôt que de se compter

au nombre de ceux qui font le choix de les adopter »

Nous

savons qu’il va devenir prioritaire pour certains pays d’agir sur la

dénatalité. Particulièrement là où cela est le plus nécessaire à savoir dans

les pays les plus pauvres. Mais ceci avec une contrepartie : leur montrer

vu qu’ils ont tendance à nous imiter, l’exemple de ce que leur politique

énergétique devrait être. Cela nous éviterait de devoir leur recommander la

frugalité. Nous devrions être plus sensibilisé par ce problème de transition

énergétique étroitement associée selon beaucoup d’expert au réchauffement

climatique. De nombreuses maisons pourtant situées en zone non inondable ont

été gravement inondée en France et ailleurs ces dernières années en raison des

dérèglements actuels du climat. Il semble déraisonnable que la consommation

d’énergie du français associée au chauffage de son logement et à sa voiture

personnelle représente plus de 50% de la consommation totale. Nous commençons

timidement à agir pour la voiture individuelle grâce au Japon mais concernant

l’habitat on ne peut pas parler de frugalité lorsqu’un pays dit

« avancé » consomme près de 10 000 kWh par habitant pour assurer le

confort thermique de son habitat. Le problème est que nous - je veux dire les

pays de l’OCDE – ne montrons pas l’exemple aux pays les plus pauvres – ou ce

qui revient un peu au même aux pays en voie de développement – l’exemple de ce

qu’il faut faire. Ceci alors qu’ils ont tendance d’imiter ceux qui consomment

le plus.

Les

rédacteurs de la prospective réalisée par l’OCDE expliquent que les dispositifs

de chauffage étant remplacés environ tous les 30 ans, il y a dans le cadre des

gaz à effet de serre une chance pour que la chaîne énergétique des nouvelles

chaufferies soit modifiée avant l’échéance 2050. C’est en partie ce commentaire

qui a motivé une étude sur l’énergie qui a pris la forme d’un livre de 640

pages « La Solar Water Economy avec la rivière » Il y

est expliqué dans le détail quel pourrait être le principe de cette nouvelle

chaine énergétique et ses performances. On peut craindre que cette « Solar Water Economy » basée sur

l’enthalpie et la chaleur spécifique de l’eau ne rentre trop lentement dans les

faits. Ceci non pas pour des raisons techniques ou scientifiques mais en raison

du conservatisme et aussi peut-être en raison de l’aspect financier. On ne peut

que le regretter vu que cette orientation montrerait aux autres pays du monde

l’exemple de ce qui peut être fait pour participer à l‘atténuation climatique.

Le

chiffre 10

L'objectif

final de la fusion nucléaire de l'hydrogène est selon Bernard Bigot,

Directeur général d'ITER (International Thermonuclear

Experimental Reactor)

de produire industriellement 10 fois plus d'énergie que l'on en consomme. À

titre d'exemple de fournir 500 mégawatts en n'en fournissant que 50. Il

n'explique pas clairement qu'elle est la forme d'énergie considérée mais on

comprend que celle-ci est thermique et que l'objectif de la fusion

nucléaire de l'hydrogène est de produire un plasma capable d'assurer une

production industrielle et contrôlée de cette forme d'énergie et ceci à très

haute température.

En

observant la figure 1 donnant le coefficient de performance Idéal

(COP) d'une pompe à chaleur, on observe que le chauffage thermodynamique est

lui aussi capable de produire industriellement 10 fois plus d'énergie thermique

que ce que consomme en énergie électrique le compresseur de cette pompe à chaleur. Ceci pour une température à la source froide de

15°C associant l’eau de la rivière à celle de l’eau géothermale et une

température à la source eau chaude égale à celle d'un plancher chauffant

hydraulique standard (40 °C) en effet :

Tf =

273 + 15 = 288 °K

Tc = 273

+ 40 = 313 °K

COP = Tc/ (Tc - Tf

) = 313 / (313 - 288) = 12,5 >

10

Cela ne signifie pas que tous les problèmes

sont résolus vu que le chauffage thermodynamique a besoin d'électricité pour

faire fonctionner la pompe à chaleur à compresseur. Pour produire de

l'électricité à la demande et en quantité suffisante en hiver il est probable

qu’avec un besoin en énergie finale 10 fois plus faible pour chauffer l'habitat

on pourra se passer du nucléaire. Un nucléaire quoiqu’on en dise synonyme du

toujours +. La radioactivité et la trop grande proximité entre les

nucléaires civils et militaires fait que la priorité devant être donnée aux

investissements devrait être d’assurer le besoin en comblant intelligemment

l’intermittence des énergies renouvelables tel cela est évoqué ci-dessous. Ceci

en tenant compte du fait que le bon sens exige dans un premier temps de mettre

en place la "Solar Water

Economy de l'enthalpie" afin de consommer moins d'énergie électrique

plutôt que d'en produire plus. En raison de la démographie croissante dans nos

cités, seule la géothermie associée à la rivière et à sa nappe libre tel que

cela est proposé dans cette « Solar Water Economy »

sera insuffisante pour assurer le besoin sans faire appel au toujours+. Nulle doute que dans le monde fini dans lequel nous

vivons il faudra combiner intelligemment ces deux systèmes en limitant au

stricte minimum voire même en arrêtant la construction de nouvelles centrales

nucléaires type EPR comme l'a proposé Nicolas Hulot. Ceci d'autant que notre

économie est régie par une croissance exponentielle incompatible avec un monde

fini.

La

densité urbaine

Avec une densité

urbaine de 20 000 habitants au km² dans Paris intra-muros et en proche région

parisienne chaque parisien ne dispose que de 50 m² au sol. Un chiffre qui ne

peut que diminuer étant donné la tendance à surélever les bâtiments en ville en

raison d'un coût au m² des terrains constructibles prohibitifs. Une réflexion

va devoir être apportée à l’évidence en ce qui concerne les réseaux d'eau non

potable en ville associés au chauffage thermodynamique et à la « Solar

Water Economy de l'enthalpie »

décrite ci-dessus. Notre seule chance de pouvoir généraliser le chauffage

urbain avec une telle densité de population en diminuant significativement nos

émissions de gaz à effet de serre va être d’associer la géothermie profonde et l’aquathermie superficielle. Ceci en

profitant du contexte de la chaufferie hybride et du réseau de

distribution en gaz des immeubles.

Le concept appelé dans le monde

anglo-saxon Power-to-Gas (PtG) utilisant les

transformations chimiques de la matière pourrait dans le contexte du réseau gaz

présenter un grand intérêt. Il serait ainsi possible d’assurer la conversion en gaz de l'électricité

excédentaire dite « verte » produite pendant la période estivale par

le voltaïque voire celle plus aléatoire de l'éolien. Ce concept pourrait

devenir essentiel pour assurer le stockage de masse de l’excédent d'électricité,

périodes pendant lesquelles la production d’électricité dépassera la demande.

La conversion de l’énergie électrique en un autre vecteur énergétique apparaît

donc comme un nouveau concept et une solution valable pour valoriser ces

excédents. Dans la pratique la technologie de base du Power-to-Gas pourrait

consister à injecter directement dans les réseaux de distribution ou de

transport de gaz naturel l’hydrogène (H2) produite en amont par

électrolyse et décomposition des molécules d'eau (H2O. Cette

technologie serait particulièrement dans le cadre de la chaufferie hybride peu

consommatrice de produit fossiles.

Dans la pratique le concept Power-to-Gas consiste

à brûler un mélange

hydrogène gaz naturel. Ceci en mélangeant l'hydrogène en phase gazeuse produite

par électrolyse de l'eau 2H20 > 2H2 + O2

avec du gaz carbonique pour obtenir du méthane par méthanation 2H2 + CO2 > CH4 + O2.

L’ademe estime

qu’avec cette chaîne énergétique la teneur en hydrogène du mélange

hydrogène-gaz naturel ne doit pas dépasser 20%. Ceci pour assurer une tenue

correcte des tuyauteries dans le temps. Il est probable que le pourcentage

gaz-méthane qui sera généralisée par la suite sera surtout fonction des

performances obtenues. Quoiqu’il advienne cela ne doit en aucun cas nous

empêcher de réfléchir aux solutions envisageables avec les réseaux d'eau Non

Potable (ENP) de la "Solar Water

Economy de l'enthalpie" envisagée ci-dessus.

Comme on le voit les solutions ne manque

pas pour assurer notre transition énergétique.

Une réflexion devra toutefois être

conduite pour évaluer le meilleur emplacement des échangeurs à plaques

constituant l'évaporateur et le condenseur de la pompe à chaleur. Ces derniers

pouvant être situés dans une zone privative comme celle d’une copropriété ou

sur un terrain communal dans le cas d'une action collective régie par exemple

par la municipalité.

L’aspect financier

A

partir du moment où l’urgence écologique semble un concept partagé par tous, il

appartient aux états de trouver des marges de manœuvre financières pour

orienter efficacement nos comportements dans le sens de la rénovation

énergétique. Cela ne va pas être facile. Selon Jean-Claude Trichet, ex-président de la

Banque centrale européenne (BCE) la situation financière actuelle est

aussi dangereuse qu'au moment de la chute de la banque américaine Lehman

Brothers en septembre 2008. Selon lui le surendettement massif des économies

avancées a été le facteur essentiel dans le déclenchement de cette crise

financière mondiale passée. Or si

"la croissance de l'endettement actuel - en particulier privé - des pays

avancés ralenti grâce aux engagements budgétaires européens qui obligent à

ramener le déficit en deçà des 3% du PIB il n'en est pas de même selon lui de

l'endettement des pays émergents qui s'est accéléré. Cela rendrait aujourd'hui

l'ensemble du système financier mondial au moins aussi vulnérable sinon plus

qu'en 2008. Si l’Etat manque d’argent, les français (du moins

une partie d’entre eux) n’en manquent heureusement pas. L’INSEE le dit dans ses

rapports : les français épargnent chaque année environ 200 milliards

d’euros. La moitié de cette somme serait affectée au remboursement des emprunts

contractés et à l’autofinancement des logements acquis, l’autre moitié orientée

majoritairement vers les contrats d’assurance-vie et les instruments d’épargne

réglementée. Le moment semble venu de supprimer progressivement le déficit du

budget en imaginant des instruments financiers innovants. Ceci afin d’affecter

chaque année une partie de cette épargne vers les investissements nécessaires à

l‘éducation, la santé, le financement de la transition énergétique. Au moins 2

aspects financiers favorables se pointent à l’horizon : le fait d’une part

que la banque mondiale prévoit un bond de 1000% de la demande en lithium et que

d’autre part l’état, par le canal de son ministre de l’écologie, ait pris

conscience qu’il est nécessaire que son ministère s’implique dans l’autoconsommation

de l’énergie électrique produite localement. Ceci dans la mesure où

ces deux prises de conscience pourraient ouvrir des perspective non seulement

vers l’autoconsommation de l’énergie électrique d’origine voltaïque produite

localement mais aussi vers le stockage par pile. Ceci principalement dans le

cadre de la voiture hybride rechargeable et sa batterie de quelque 10 kWh.

On

peut aussi ouvrir le débat sur la création de fonds d’investissement citoyens

qui prendraient le relais financier d’un état impécunieux afin de faire face

aux investissements régaliens les plus lourds et les plus urgents pour l’avenir

du pays. Notamment celui du financement des infrastructures nécessaires à la

mise en œuvre de la transition énergétique.

Il

ne s’agit pas ici d’un bouleversement mais le porte-parole du CSLT estime à ce

sujet qu’il va devenir urgent de revoir sensiblement notre modèle économique.

Ce modèle étant basé pour l’essentiel sur le prix de l’énergie ; nous

allons devoir prendre conscience qu’il y a une autre méthode que celle utilisée

actuellement pour équilibrer notre budget. Ceci en faisant appel à la notion de

vases communicants. La vision financière de notre modèle économique qu’ont

actuellement nos distributeurs d’énergie est la suivante : tenter de fixer sur

le court terme disons 3 ans un prix de vente à l’utilisateur du kWh électrique

3 fois supérieure à celui du kWh gaz. L’impression donnée par cette situation

semble être purement financière. Ceci pour les raisons suivantes :

–

Soulagerait

le médiateur de l’énergie en diminuant la précarité énergétique.

Le porte-parole des lutins thermiques attire

l’attention sur le fait que cette nouvelle orientation de notre modèle

économique ne modifierait pas le budget de la France du fait de cette notion de

vases communicants, le manque à gagner sur l’électricité étant compensé par une

augmentation de la fiscalité sur la vente des produits fossiles équilibrant

ainsi leur budget.

Ceci comme cela est déjà le cas de l’essence pour la

voiture individuelle ou le camion avec le fret routier.

|

La terrible échéance réside dans le fait que

selon Stephen Hawking célèbre astrophysicien britannique, les humains devront

quitter la Terre d'ici un siècle pour survivre s’ils ne prennent pas

conscience de la dangerosité

de la croissance en changent le système |

|

Avons-nous tiré les leçons de la crise financière de

2007-2008 ?

Après

ces dix années passées, la réponse est mitigée si l’on considère ce qui précède

juge et les alertes lancées par certains banquiers, économistes et

universitaires.

Elle

est négative si l’on compare les ambitions affichées par les gouvernants lors

des multiples sommets du G20 depuis 2008 en matière de régulation financière,

notamment la séparation des activités de banque de dépôts et de banque

d’affaire et le renforcement des fonds propres des banques. Non si l’on en juge

par les analyses récentes du Groupe des 30, du FMI et de la BRI. Pourtant,

quelques avancées pour renforcer le système financier ont été faites : la loi

Dodd-Frank de 2010 aux Etats-Unis, l’Union Bancaire Européenne avec la

supervision unique des plus grandes banques et le Fonds de Résolution, les

directives MIFID de régulation des marchés d’instruments financiers. D’autres

batailles ont été plus médiatisées : la lutte contre les paradis fiscaux, les

échanges automatiques d’informations fiscales entre les Etats.

En

dépit de ces évolutions règlementaires qui se sont traduites par 40 directives

européennes et 400 règlements techniques standard, d’une complexité extrême,

donc difficilement applicables et difficilement contrôlables, les résultats ne

sont pas au rendez-vous.

Sur

certains thèmes abordés par le G20, « la montagne aurait accouché d’une

souris » selon les déclarations récentes de Christophe Nijdam, membre du

Collège de l’Autorité Bancaire Européenne (ABE), s’exprimant à titre personnel.

Parmi les mesures décidées lors du G20 de Londres en 2009 figurait le

renforcement du contrôle prudentiel. Les résultats sont très en dessous des

objectifs. Ainsi, selon Christophe Nijdam, alors que la Fédération Bancaire

Européenne avait évalué les effets de Bâle III en matière de fonds propres

additionnels à 900 milliards €, les décisions prises le 16 décembre dernier ont

ramené ce chiffre à 40 milliards €. C’est le résultat de la pression des 1600

lobbyistes bruxellois de la finance.

Figurait

aussi au programme du G20 de Londres la lutte contre les effets cycliques dus

aux crises. En France, le Haut Conseil de Stabilité Financière (HCSF) a été

chargé de mettre en œuvre le « coussin de fonds propres contra

cyclique » des banques. Son entrée en vigueur était fixée au 1er janvier

2016. Deux ans plus tard, ce coussin reste vide. Le 29 décembre dernier, le

HCSF a décidé que le taux appliqué serait maintenu à 0% du montant des actifs

pondérés des risques.

Devons-nous

en déduire que la solidité du système financier ne s’est pas améliorée depuis

dix ans ? Oui, c’est bien exact. Le Groupe des 30 l’affirme dans un rapport de

novembre 2016 « Shadow Banking and Capital Markets ».

La conclusion est claire. Les risques ont changé de nature en dix ans et sont

globalement aujourd’hui aussi importants qu’avant la crise de 2007. « Overall risks are as

great now as they were before the crisis. » La compétence des auteurs du rapport ne peut être

mise en doute : Jean Claude Trichet (ex-BCE), Jaime Caruana

(BRI), Richard Debs (FED), David Walker (Barclays Plc,…

Ce rapport confirme ce que disent des économistes et des universitaires : les

problèmes viennent des banques, mais en parie seulement.

La

Banque des Règlements Internationaux (BRI), dans son dernier rapport

trimestriel parle d’une « énigme financière » et déclare que les

risques s’intensifient. Cet avis n’est pas étranger au fait que les économies

sont dopées artificiellement par les injections massives de liquidités par

certaines banques centrales avec maintien des taux d’intérêt proches de 0%.

La

Banque de France, dans ses statistiques récentes, indique un taux de croissance

annuel des crédits distribués de 5 à 6%, tant pour les entreprises que pour les

particuliers, ce qui est beaucoup au regard du taux de croissance du PIB et du

taux relativement faible de l’inflation.

Mais,

les problèmes majeurs ne viennent pas seulement des banques mais de ce que l’on

appelle le « Shadow Banking ». C’est à dire les activités financières

des institutions non bancaires : produits dérivés, titrisation, hedge funds, gestion d’actifs,

etc… le shadow banking

avait explosé dans les années 2000 à 2007, notamment aux Etats-Unis. Dans ce

pays, les prêts non bancaires représentent 68% des crédits au secteur privé

alors qu’en Europe Occidentale ce taux n’est que de 32%.

Le

Groupe des 30 constate que les activités les plus risquées du shadow banking à savoir les CDS (Credit Default Swaps) se sont considérablement réduites

entre 2007 et 2014. En revanche, la dette corporate

des pays émergents a plus que triplé entre 2007 et 2014, surtout en Chine.

Le

Fond Monétaire International (FMI) dénonce, depuis 2015, l’excès d’endettement

des entreprises chinoises et des pays émergents, avec le risque de bulle que

cet excès comporte et qui constitue une des données d’un « scenario

noir ». Plus généralement, il est difficile d’appréhender l’importance des

activités de shadow banking,

tant les chiffres divergent d’un institut à l’autre, le périmètre n’étant pas

uniformément défini. Certains économistes les évaluent entre 75 et 80 000

milliards €, montant supérieur au PIB mondial. De son côté, le Groupe des 30

les évaluent à 56 000 milliards $ en 2014.

Autre

source d’inquiétude : les montants gigantesques des produits dérivés.

La

Banque des Règlements Internationaux (BRI) publie régulièrement les encours

notionnels des dérivés de gré à gré. L’encours était de 542 435 milliards $ au

1er semestre de 2017 contre 710 000 milliards $ fin 2013. Les contrats sont

concentrés sur quelques grandes banques internationales. Les 3/4 d’entre eux

concernent les taux d’intérêt. Une variation brutale et non contrôlée des taux

d’intérêt provoquerait une grande instabilité sur ce marché.

A

la suite du G20 de Pittsburg en septembre 2009, les autorités ont pris des

mesures pour obliger les opérateurs à enregistrer leurs opérations de dérivés

dans une chambre de compensation, les USA avec la loi Dodd-Frank et l’Union

Européenne avec les règlements EMIR et MIFID II. Mais le FMI, dans un rapport

d’avril 2010, constate qu’un tiers des contrats dérivés ne seraient pas

compensables parce qu’insuffisamment standardisés et liquides. Le Comité de

Bâle, pour pallier cette difficulté, a instauré un système d’appel de marge

pour les contrats non compensables. Cette obligation entrera en vigueur

jusqu’en 2019.

Autre

source d’instabilité du système financier : le Trading Haute Fréquence. Cette

pratique consiste à inonder les marchés boursiers d’un nombre incommensurable

d’ordres d’achat et de vente qui sont en quasi-totalité annulés avant

exécution, et ceci, dans des laps de temps très courts : 1 ou 2 millionième de seconde. L’Autorité des Marchés Financiers

(AMF) dans une étude sur le « Comportement des traders haute fréquence

(THF) sur Euronext Paris » de janvier 2017, remet en cause l’utilité des

traders haute fréquence : « Dans l’ensemble, les THF consomment plus de

liquidité qu’ils n’en apportent et cela est plus remarqué durant les séquences

de volatilité »… alors que c’est dans ces

périodes qu’il faudrait au contraire apporter de la liquidité. Dans le même

temps, à propos du même document, certains commentateurs écrivaient : » Le

trading haute fréquence, un soutien important à la liquidité, selon l’AMF « (Agéfi 27 janvier 2017). C’est dire que les avis sont

partagés. Beaucoup d’observateurs cependant critiquent cet outil apparu en 2007

en dénonçant ces pratiques comme apparentées à une manipulation des cours. La

Commission des sanctions de l’AMF a d’ailleurs prononcé des sanctions sur la

base de ce grief. L’une est datée du 4 décembre 2015 à l’encontre de la société

américaine MTE-Virtu à hauteur de 5 millions €. Une

autre est datée du 8 juillet 2016 à l’encontre de la société britannique Getco à hauteur de 400 000 €. Le trading haute fréquence

conduit à prendre des décisions qui, si elles sont rationnelles, n’en sont pas

moins aberrantes. Par exemple le transfert physique à Londres des ordinateurs

de la Bourse de Paris pour gagner quelques millionièmes de seconde. Compte tenu

des besoins de la société française, il est permis de s’interroger sur le pertinence de cette allocation de ressources. Le trading

haute fréquence contribue à générer une méfiance du public à l’égard du

fonctionnement des marchés boursiers en créant une inégalité d’accès aux

informations, selon que l’on dispose ou non d’ordinateurs puissants, des

algorithmes jalousement gardés et des réseaux nécessaires. Par les masses de

capitaux que le trading haute fréquence manipule, cette activité présente un

risque de déstabilisation des marchés comme cela s’est produit sur la bourse de

New York le 6 mai 2010 quand en l’espace de 10 minutes, l’indice Dow Jones a

chuté de près de 10%.

Il

est légitime de se poser la question : pourquoi après dix ans les gouvernants

ne sont-ils pas parvenus à obtenir la consolidation annoncée du système

financier international. C’est peut-être en raison du poids économique des

grandes multinationales dont certaines détiennent des milliards $ de cash. En

face, les Etats sont sortis de la crise exsangues avec

des taux d’endettement public gigantesques.

Peut-on

dans ces conditions se présenter en pourfendeur de la finance ou

s’autoproclamer Jupiter ? Une fois évaporée l’ivresse d’une victoire

électorale, dès le lendemain, il faut envoyer les agents de l’AFT à Canossa

pour se soumettre au bon vouloir des marchés financiers et leur emprunter près

de 200 milliards € par an, 120 milliards pour l’amortissement de la dette

existante et 80 milliards pour le déficit annuel (cf. PLF 2018).

Texte écrit par deux Lutins

thermiques en septembre 2018

* Stephen Hawking estime que nous avons déjà scellé le destin de

l'Humanité et que dans moins de 100 ans, les sociétés humaines ne seront plus.

Cette vision peut sembler extrêmement pessimiste et faire sourire (jaune).

Toujours est-il que sur le long terme une croissance exponentielle ne peut pas

durer dans un domaine fini comme celui de notre planète. La solution qui

consiste pour faire simple à choisir dans un premier temps le soleil et l'eau

plutôt que l'atome et les dérivés du pétrole nous permettrait probablement de

tenir quelques siècles de plus mais sur le long terme, c'est-à-dire le

millénaire, il faut se rendre à l'évidence : notre seule chance que

"l'avenir de l'homme soit sur terre" est que nous nous arrangions de

telle sorte que nos besoins en énergie n'excèdent pas les capacités naturelles

de production de notre planète. Il est probable que nous n'arriverons pas à

changer la terre et que notre souhait d'y implanter le Soleil avec ITER ne saurait se concrétiser au mieux avant

une soixantaine d’année. Dans l’intérim,

soyons concret et ne montrons pas le mauvais exemple en construisant sur notre

territoire 6 nouveaux EPR avant même d'avoir mis en place le démantèlement des

anciennes centrales et solutionné le stockage des déchets radioactifs. Evitons

dans un premier temps le toujours+, incitons au

renouvelable en baissant le prix de revient de l’énergie électrique

grâce au soleil et en augmentant le prix des combustibles fossiles

*CLST au choix du lecteur « Conseil supérieur des Lutins

thermiques » ou « Conseil

Supérieur de la Législation Thermique »